UNA PÁGINA PARA PUBLICAR LAS BARBARIDADES MÉDICAS,LOS ROBOS DE LOS LABORATORIOS,LAS MEDIDAS PROGRESISTAS Y LAS NOVEDADES MEDICAS MUNDIALES

lunes, 23 de marzo de 2015

Inteligencia artificial: ¿Progreso o amenaza existencial?

Aunque quizá, como dice Max Tegmark, «la mayor amenaza de la humanidad sea nuestra propia estupidez»

POR MAR ABAD ( @MARABAD )

E

sto era un día cualquiera en la Tierra. Un alienígena de una civilización superior envió un mensaje a un terrícola y le dijo:

—Hola. Somos los marcianos y llegaremos al tercer planeta dentro de un par de décadas.

—De acuerdo. Llamadnos cuando lleguéis. Y… por cierto, ¿os dejamos las luces encendidas?

—De acuerdo. Llamadnos cuando lleguéis. Y… por cierto, ¿os dejamos las luces encendidas?

Pongamos que esos terrícolas son los científicos de hoy y que los extraterrestres representan la Inteligencia Artificial (IA). Las orejas del lobo son las mismas.

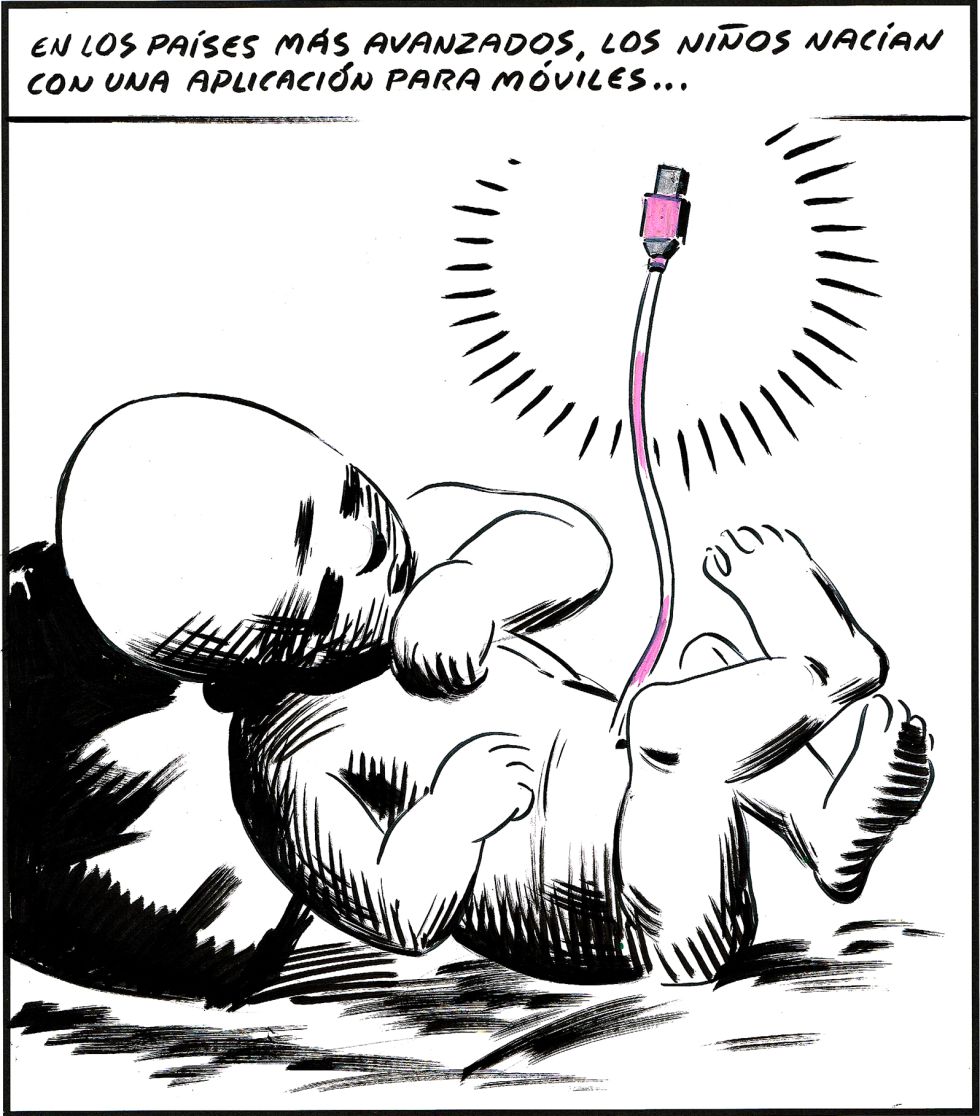

(Ilustración de Valistika)

Esta escena muestra, según cuatro investigadores, la despreocupación actual de gran parte de la comunidad científica respecto a las maldades que podrían hacer las máquinas el día que sean más listas que los humanos. El escenario apareció en un artículo escrito por Stephen Hawking (director de investigación del Centro de Física Teórica de Cambridge), Max Tegmark (autor de Our Mathematical Universe), Stuart Russell (coautor de Artificial Intelligence: a Modern Approach) y Frank Wilczek (profesor de Física en el MIT) el pasado mes de abril.

En el texto, titulado Transcending Complacency on Superintelligent Machines, decían que la IA nos ha llevado ya a un mundo donde los coches saben conducirse solos y donde tienes a un asistente personal metido en el móvil. Hasta ahí todo bien, pero esa misma inteligencia también sabe ya cómo elegir y atacar un objetivo militar sin que ningún soldado dé la orden.

Es la misma inteligencia que temen muchos economistas como Erik Brynjolfsson y Andrew McAfee. Estos autores advierten en su libro The Second Machine Ageque los algoritmos tienen cada vez más poder en las cuentas del mundo y que ya han causado algunos temblores en los mercados financieros.

La IA está creciendo a una velocidad incierta. Para unos, demasiado rápido. «El riesgo de que ocurra algo realmente peligroso está a solo cinco años. Diez, máximo», escribió Elon Musk en el blog Edge.org. El fundador de SpaceX es uno de los grandes agoreros de nuestro tiempo sobre los peligros de esta tecnología, aunque quizá, en esa ocasión, se aceleró al teclado porque al poco borró lo dicho.

Y para otros, avanza demasiado despacio. Eric Schmidt dijo en una entrevista con la revista Wired que estas máquinas son mucho más primitivas de lo que cualquiera pueda imaginar. El presidente ejecutivo de Google trabaja en el desarrollo de sistemas inteligentes como el vehículo autónomo y las búsquedas predictivas. Lleva décadas entre máquinas y sabe el recelo que han despertado siempre. Desde hace siglos, dicen que roban el trabajo a los humanos, pero, según Schmidt, esto no está tan claro. Quizá podían estar dignificándolo. Él piensa que hay pruebas de que, en general, las personas que trabajan con un ordenador cobran un sueldo mayor que las que desempeñan otros oficios. La única amenaza que se plantea es que ningún sistema educativo en el mundo está enseñando a los niños a utilizar y conocer bien unos dispositivos que cada día son más inteligentes.

Los cuatro firmantes de Transcending Complacency on Superintelligent Machines escribieron que pueden imaginar perfectamente una tecnología capaz de intervenir en los mercados financieros, manipular a los líderes humanos y desarrollar armas que las personas ni podemos comprender. «El impacto de la IA depende, a corto plazo, de quién lo controle y, a largo, de si puede ser controlada de algún modo».

STEPHEN HAWKING: «EL DESARROLLO TOTAL DE LA INTELIGENCIA ARTIFICIAL PODRÍA LLEVAR A LA EXTINCIÓN DE LA RAZA HUMANA» BBC, DICIEMBRE 2014

Hace tiempo que esta inquietud empezó a levantar instituciones de investigación sin ánimo de lucro. El Centro de Estudios de Riesgo Existencial de Cambridge, el Instituto del Futuro de la Humanidad, el Instituto de Investigación de las Máquinas Inteligentes o el Instituto del Futuro de la Vida (FLI). Este último ha publicado un manifiesto en el que 400 científicos plantean unas guías para «maximizar los beneficios y minimizar las potenciales dificultades» de la IA. Entre las firmas del documento, titulado Research priorities for robust and beneficial artificial intelligence, están Hawking, Max Tegmark, Elon Musk y cientos de profesores de las mejores universidades del mundo.

Musk se lo ha tomado en serio. Ha donado 10 millones de dólares al Instituto del Futuro de la Vida para investigar cómo podemos asegurarnos de que la IA no se volverá contra los humanos. El CEO de la compañía de coches eléctricos Tesla Motors llegó a decir en una conferencia de Vanity Fair que la inteligencia artificial en un estadio avanzado podría crear robots que aniquilara a humanos como hoy borramos spam, y en otra ocasión soltó que «potencialmente es más peligrosa que los misiles nucleares».

Pero esta copla del fin del mundo de un plumazo no es nueva. La mayor amenaza de la raza humana no son los marcianos. Es la propia raza humana. Nosotros hemos creado las armas de destrucción masiva. Un científico como Nikola Tesla hablaba del ‘rayo de la muerte’. Albert Einstein escribió una carta al presidente Roosevelt para recomendarle que lanzara su terrorífica bomba atómica en la cabeza de los japoneses.

«La mayor amenaza de la humanidad es nuestra propia estupidez», confesó Tegmark en una entrevista en The Atlantic. Y, efectivamente, su argumento es irrebatible. Hay más personas que conocen a Justin Bieber que a Vasili Arkhipov, un oficial soviético que evitó la guerra termonuclear en la crisis de los misiles en Cuba de 1962, o que a Bo Jackson, uno de los grandes atletas de todos los tiempos.

MAX TEGMARK: «DE LO QUE DEBERÍAMOS PREOCUPARNOS ES DE QUE NO ESTAMOS PREOCUPADOS» THE ATLANTIC, MAYO 2014

En esa estupidez, dicen algunos, se incluye imaginar la inteligencia artificial como un humano o una mascota. Uno de los fundadores del Instituto del Futuro de la Humanidad, Nick Bostrom, advierte de que estas máquinas, aunque pudieran parecerlo, nunca serían como una persona. El científico cree que hay que pensar que es un dispositivo con poder e indiferencia y que, al jugar al ajedrez, se puede ver claramente. La máquina desplaza una ficha, predice posibles respuestas y, en función de lo que haga el adversario, analiza y mueve después. Desde la frialdad de los algoritmos. Punto.

Hawking comparte esa sensación de que las máquinas no tienen escrúpulos. El científico vive con una de ellas: el artefacto que traduce sus pensamientos al resto del mundo. Un día del último diciembre el cosmólogo hablaba con la BBC. Dialogaban sobre el nuevo software de Intel que había empezado a utilizar su asistente lingüístico inerte. Unos ingenieros y expertos en educación habían creado un programa que va aprendiendo cómo piensa el científico para adelantarse a las palabras que quiere decir y acelerar, así, el ritmo de su conversación. Una especie de escritura predictiva de móvil pero llevada al pensamiento.

Esta máquina es aún una forma muy básica de inteligencia artificial. Pero no importa que aún esté en su más remota infancia. El cosmólogo ya ve las orejillas al lobo. Reconoce que estas tecnologías son muy útiles (¡faltaría más!), pero, a la vez, teme a un artefacto mucho más astuto que el humano. El bicho digital podría hacerse independiente y rediseñarse constantemente para ser cada vez más potente. «Los humanos estamos limitados por una evolución biológica muy lenta», dijo a la BBC. «No podríamos competir con ese tipo de inteligencia y acabaríamos siendo suplantados por ella».

Eso sería la encarnación de la peor pesadilla distópica. Los inventores que acaban siendo devorados por los monstruos que criaron. «El esfuerzo por crear máquinas más inteligentes que nosotros podría llevar al exterminio de la raza humana», indicó Hawking esa mañana de frío inglés.

(Ilustración de Valistika)

Ray Kurzweil no ve la cosa tan dramática. El director de ingeniería de Google tiene una fecha exacta. En 2029 las máquinas podrán flirtear, aprender de su propia experiencia y hacer chistes. El ingeniero computacional ha escrito cinco libros sobre inteligencia artificial y piensa que tampoco hay que temerle tanto. Al fin y al cabo, «ha conseguido mejorar el diagnóstico y la cura de enfermedades, desarrollar energías renovables, limpiar la atmósfera, ayudar a personas con discapacidades (incluso ha dado voz a Hawking) e innumerables cosas más».

El futurista escribió esta lista, el pasado diciembre, en un artículo titulado Don’t Fear Artificial Intelligence. Ahí decía que es cierto que hay que andarse con cuidado. La inteligencia artificial, efectivamente, podría ser un peligro para la humanidad. Pero también lo son las bombas y la injusticia social.

«Si la IA se convierte en una amenaza existencial, no será la primera. La humanidad introdujo un riesgo existencial cuando yo era un niño sentado en mi pupitre durante la Guerra Fría en los años 50», siguió. Desde entonces la distopía más paranoica podía envolver el mundo. Desde la muerte de millones de personas con solo pulsar un botón a un virus bioterrorista que arrasara con la raza humana.

Esto, por el momento, no ha ocurrido. La IA tampoco tiene que exterminar a la población mundial si se establecen unos estándares éticos. Kurzweil toma como ejemplo la biotecnología. Dice que va un par de décadas por delante de la inteligencia artificial. En 1975 organizaron un encuentro, Asilomar Conference on Recombinant DNA, para asegurarse de que la evolución de esta disciplina no traería problemas. El documento ha funcionado. Veinte años después la biotecnología ha hecho volar a la medicina y, por el momento, no ha provocado ninguna catástrofe.

ELON MUSK: «CON LA INTELIGENCIA ARTIFICIAL ESTAMOS INVOCANDO AL DEMONIO» MIT CAMBRIDGE, OCTUBRE 2014

Esto es justamente lo que ahora tratan de hacer las instituciones preocupadas por el futuro de la humanidad. Kurzweil ve razonable «definir la misión de cada programa de IA y construir dispositivos de seguridad encriptados que eviten usos no autorizados». Pero el remedio más efectivo para que las máquinas no se disloquen es «trabajar en el gobierno humano y las instituciones sociales», escribió el ingeniero. «Ya somos una civilización humano-máquina. El mejor modo de evitar un conflicto destructivo en el futuro es continuar avanzando en nuestros ideales sociales. Esto ya ha conseguido reducir mucho la violencia».

Este es uno de los argumentos que más utiliza el otro bando. El que opina que Hawking y Musk han dramatizado un poco. El psicólogo experimental de la Universidad de Harvard Steven Pinker y otros científicos creen que el avance de la civilización tecnológica va acompañado de una reducción de la violencia. «Este descenso se debe, claramente, al hecho de que el progreso de la ciencia y la tecnología se debe al intercambio de ideas libres y no violentas entre los científicos y los ingenieros. La violencia entre los humanos es un residuo de nuestro pasado tribal. La IA nacerá como individuo, no como miembro de una tribu, y tendrá una actitud científica de no violencia», asegura el profesor de Física Matemática Frank Tipler en un artículo de Edge.org.

Decidir si la inteligencia artificial es peligrosa o milagrosa no es tan fácil. En realidad, ahora mismo, depende más de la mirada de los humanos que de las máquinas en sí. El fundador de la compañía Embody Corp, Roman Ormandy, considera en su artículo Google and Elon Musk to Decide What Is Good for Humanity que el objetivo desde el que se observa el asunto está viciado. «Los investigadores de la IA de hoy son hijos de René Descartes. Confían en el poder absoluto de la lógica y las matemáticas, y nos imponen su religión del dualismo cartesiano (la división entre el cuerpo y el alma)».

El asunto también es complejo porque, según Pedro Mujica, ni siquiera se sabe aún qué es realmente la inteligencia. El tecnólogo humanista recuerda que, como indicó Noam Chomsky, ni siquiera conocemos cómo es el proceso de aprendizaje humano. «Lo único que sabemos es que imaginamos la mayor parte de la realidad para dar continuidad y sentido a nuestras percepciones fragmentadas y a la enorme complejidad que nos rodea», explica. «Tendemos a construir conceptos simples de lo complejo. Ese es nuestro mecanismo de supervivencia. La mayor parte del tiempo estamos equivocados, pero somos muy adaptables a casi cualquier entorno. Y justamente por eso somos seres emocionales que vivimos equivocados, aunque enormemente ilusionados por lo que solemos pensar y sentir».

MURRAY SHANAHAN: «NO HAY NECESIDAD DE CAER EN PÁNICO AHORA, AUNQUE ES BUENA IDEA QUE LOS INVESTIGADORES DE LA IA EMPIECEN A PENSAR YA EN LO QUE PLANTEA STEPHEN HAWKING» BBC, DICIEMBRE 2014

Dice Mujica que estas emociones son «casi imposibles de representar en una IA a día de hoy». Se han producido «enormes avances en máquinas emocionales, pero aun así están a años luz del ser humano». La IA ha ido avanzando en «máquinas predictivas, máquinas basadas en la lógica y en la potencia de cálculo, pero que no entienden al ser humano y que, si tuvieran que elegir entre ellas o nosotros, probablemente, nos verían como una amenaza para su propia evolución».

El desarrollo de la IA tendrá que elegir entre dos caminos. El de la lógica o el de la emoción. El primero sigue los pasos que propuso Asimov con sus leyes de la robótica y, según el tecnólogo, está muy controlado. El segundo es una ruta más larga, pero, quizá, la más deseable. El objetivo es construir máquinas emocionales capaces de establecer una verdadera empatía con los humanos. «Máquinas que nos amen por lo que somos, como TARS en la película Interstellar, aunque esta segunda vía es la más difícil porque primero debemos descubrir bien cómo funcionamos nosotros». TARS es el único miembro de la tripulación de la nave en busca de exoplanetas que no es humano. Es ese robot ‘abrazable’ que te ayuda siempre y te dice: «Tengo una luz que puedo encender para mostrarte cuándo estoy bromeando, si te parece bien».

La inteligencia artificial, los humanos y el futuro están ahí a ver qué pasa. La cosa promete. Kurzweil, ese tipo que Forbes definió como ‘la máquina de pensar suprema’,

dice en su artículo que «en las próximas décadas tendremos la oportunidad de avanzar decisivamente en los grandes retos de la humanidad».

dice en su artículo que «en las próximas décadas tendremos la oportunidad de avanzar decisivamente en los grandes retos de la humanidad».

La inteligencia artificial es una de las protagonistas del destino. Y el progreso, según el estadounidense, girará en torno a estas máquinas. «Tenemos el imperativo moral de asumir este compromiso a la vez que debemos ser conscientes de los peligros que conlleva», asevera. «Y no será la primera vez que hayamos triunfado en hacer esto».

Suscribirse a:

Comentarios (Atom)